Sådan bruger du Robots.Txt til at blokere underdomæner

Et websted er en god måde at fremme din lille virksomhed på, samt vise dine produkter og unikke kvalifikationer. Hvis du styrer et stort websted, bruger du sandsynligvis nogle få underdomæner, og hvert underdomæne har sin egen mappe på din webhost. Hvis du ikke vil have søgemaskiner til at analysere og indeksere bestemte underdomæner, kan du bruge robots.txt-filen til at blokere dem.

1.

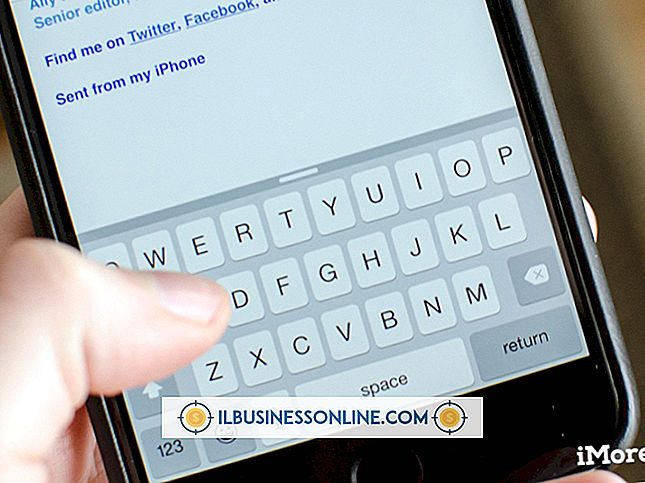

Klik på knappen Start i nederste venstre hjørne af skærmen.

2.

Skriv "Notepad" i søgefeltet nederst på startmenuen.

3.

Klik på "Notesblok" i afsnittet Programmer øverst på startmenuen for at starte Notesblok. Et nyt dokument oprettes automatisk i Notesblok.

4.

Indsæt disse to linjer i Notepad-dokumentet for at blokere alle robotter fra at analysere underdomænet:

Brugeragent: * Tillad: /

5.

Tryk på "Ctrl-S" for at åbne vinduet "Gem som".

6.

Indtast "robots.txt" i feltet "Filnavn", vælg en mappe, hvor du vil gemme filen, og klik på "Gem" for at gemme den.

7.

Upload robots.txt-filen, du har gemt, til rodmappen for hvert domæne, som du vil beskytte fra søgemaskinerne. Roten mappen er topniveauet mappen.

Tip

- Du kan uploade filen ved hjælp af en FTP-klient-software eller endda din vært's webfilhåndtering.